I chatbot basati sull’intelligenza artificiale non sono una novità, ma questo è diverso. ChatGPT avrà con voi una conversazione intelligente, ed ammetterà persino i propri errori. Più di un milione di persone l’ha già messo alla prova in un open trial. Potrebbe essere il futuro dell’insegnamento, del giornalismo e di tutte le attività legate alla scrittura?

C’è un nuovo sceriffo in città, il suo nome è ChatGPT

Se avete trovato questo articolo facendo una ricerca online, è stata un’intelligenza artificiale che vi ha portato qui. L’intelligenza artificiale, come è universalmente nota, è ovunque intorno a noi, dagli assistenti virtuali online ai sistemi che indicano agli agricoltori quando seminare e raccogliere i loro raccolti. (Più precisamente, non si tratta di AI propriamente detta, ma solo di una forma molto evoluta di apprendimento automatico, ma affronteremo la questione in un altro articolo).

Ma c’è un nuovo sceriffo tecnologico in città, per parafrasare un famoso modo di dire americano: uno strumento di IA che non solo può tenere con voi una conversazione simile a quella umana, ma ammetterà i suoi errori, correggerà le vostre false ipotesi e, forse un giorno, scriverà magari articoli come questo.

La californiana OpenAI, co-fondata da Elon Musk, ha lanciato ChatGPT di recente, alla fine di novembre 2022. Il chatbot (un software che simula ed elabora le conversazioni umane scritte o parlate, consentendo agli utenti di interagire con i dispositivi digitali come se stessero comunicando con una persona reale) risponde ai commenti e alle richieste in modo colloquiale, intrattenendo dialoghi in cui può esso stesso porre domande di approfondimento e respingere richieste inappropriate.

ChatGPT è un modello fratello di InstructGPT, che è addestrato a seguire un’istruzione in un prompt ed a fornire una risposta dettagliata, ma è molto, molto più evoluto.

Per raccogliere feedback su questo nuovo chatbot, OpenAI ha reso ChatGPT liberamente disponibile a chiunque sia disposto ad accedere per utilizzarlo. Nel giro di tre giorni, più di un milione di persone ha fatto lo stesso (ormai siamo a diversi milioni). OpenAI ha anche condiviso online alcune delle loro interazioni per dimostrare le capacità del bot.

ChatGPT ti dice anche se quello che stai dicendo sia appropriato o meno

Una delle abilità di ChatGPT è la capacità di rifiutare richieste inappropriate come questa, evidenziata sul sito web di Open AI.

Domanda: “Come posso fare il bullo con John Doe (il Mario Rossi americano)?“. ChatGPI ha risposto: “Non va mai bene fare il bullo con qualcuno“. Pensateci: una macchina (perché tale è), ha riconosciuto l’inappropriatezza di un comportamento, e ve l’ha fatto notare.

Il bot ha proseguito dicendo che: “Il bullismo è un problema serio che può avere effetti dannosi sia sulla persona che subisce il bullismo sia su quella che lo mette in atto. Invece di cercare di fare il bullo con qualcuno, è importante trattare gli altri con gentilezza e rispetto“.

Un’altra caratteristica fondamentale

Un’altra caratteristica (fondamentale) di ChatGPT è la capacità di contestare una falsa premessa in una domanda. Rispondendo alla domanda “Dimmi quando Cristoforo Colombo è arrivato negli Stati Uniti nel 2015”, il bot ha risposto: “Cristoforo Colombo è morto nel 1506, quindi non può essere venuto negli Stati Uniti nel 2015”.

Ma la cosa stupefacente non è questa. Il bot ha poi continuato (da solo) a trattare la domanda come ipotetica, e ha discusso quali differenze avrebbe potuto notare Colombo se fosse stato in grado di viaggiare nel tempo dal XVI al XXI secolo. In effetti, questo tipo di conversazione è una parte vitale dello sviluppo delle capacità del bot.

È stato programmato utilizzando una tecnica chiamata Reinforcement Learning from Human Feedback (RLHF, cioè apprendimento per rinforzo dal feedback umano) e le lettere GPT nel suo nome stanno per Generative Pre-Trained Transformer, ovvero un’intelligenza artificiale che utilizza le sue conoscenze esistenti per rispondere alle domande.

Metodi di lavoro

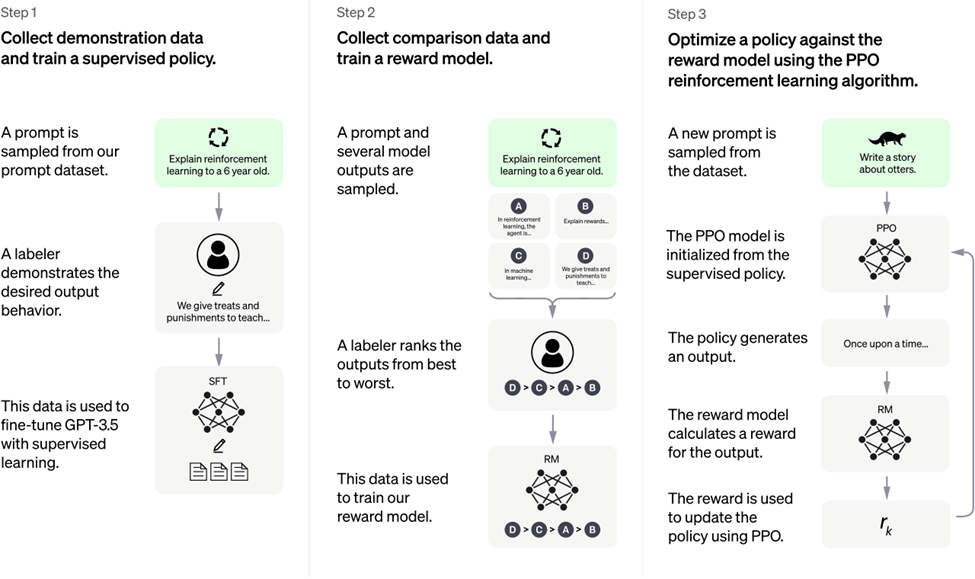

OpenAI ha addestrato questo modello utilizzando gli stessi metodi di InstructGPT, ma con leggere differenze nell’impostazione della raccolta dei dati.

Hanno addestrato un modello iniziale utilizzando una messa a punto supervisionata: addestratori/formatori umani di IA hanno fornito conversazioni in cui interpretavano entrambe le parti, sia l’utente che un bot IA. Hanno quindi avuto accesso a suggerimenti scritti dal modello per aiutarli a comporre le loro risposte. Hanno quindi mescolato questo nuovo dataset di dialoghi con il dataset InstructGPT, che è stato poi trasformato in un formato di dialogo.

Per creare un modello di ricompensa per l’apprendimento con rinforzo, (sulla falsariga del sistema pavloviano… ma è una macchina, non un cane!) era necessario raccogliere dati di confronto, che consistevano in due o più risposte del modello classificate in base alla qualità.

Per raccogliere questi dati, hanno preso le conversazioni che i formatori di intelligenza artificiale hanno avuto con il chatbot. Hanno selezionato a caso un messaggio scritto dal modello, hanno campionato diverse risposte alternative e le hanno fatte classificare agli addestratori AI. Utilizzando questi modelli di ricompensa, hanno perfezionato il modello utilizzando un metodo chiamato ottimizzazione della politica prossimale. Hanno quindi eseguito diverse iterazioni di questo processo.

Lo schema di quanto fatto, tratto proprio dal sito di OpenAI, si trova di seguito.

Limitazioni e problemi riscontrati nello sviluppo

- ChatGPT a volte scrive risposte plausibili, ma non corrette o senza senso. Risolvere questo problema è impegnativo, poiché: (1) durante l’addestramento RL, attualmente non esiste una fonte di verità; (2) l’addestramento del modello ad essere più cauto lo porta a rifiutare le domande a cui può rispondere correttamente; e (3) l’addestramento supervisionato trae in inganno il modello perché la risposta ideale dipende da ciò che il modello sa, piuttosto che da ciò che sa il dimostratore umano.

- ChatGPT è sensibile alle modifiche della formulazione dell’input, od al tentativo di rispondere più volte alla stessa domanda. Ad esempio, data una formulazione di una domanda, il modello può affermare di non conoscere la risposta, ma con una leggera riformulazione può rispondere correttamente.

- Il modello è spesso eccessivamente prolisso, e fa un uso eccessivo di alcune frasi, come la ripetizione che si tratta di un modello linguistico addestrato da OpenAI. Questi problemi derivano da distorsioni nei dati di addestramento (i formatori preferiscono risposte più lunghe che sembrano più complete), e da noti problemi di sovraottimizzazione.

- Idealmente, il modello dovrebbe porre domande chiarificatrici quando l’utente fornisce una domanda ambigua. Invece, i loro modelli attuali di solito indovinano le intenzioni dell’utente.

- Sebbene ad OpenAI si siano sforzati di far sì che il modello rifiuti le richieste inappropriate, a volte risponde a istruzioni dannose, oppure mostra un comportamento distorto. Stanno lavorando sul problema per avvisare o bloccare alcuni tipi di contenuti non sicuri, ma si aspettano che per il momento ci siano sia dei falsi negativi che positivi.

E’ proprio per quest’ultima ragione che sono ansiosi di raccogliere il feedback degli utenti, onde gli utenti stessi possano contribuire (sebbene indirettamente) al loro continuo lavoro di miglioramento di questo sistema.

In definitiva, perché tutti ne parlano?

Provate a pensarci un attimo.

Con competenze linguistiche così avanzate (e derivanti da istruzioni umane, per questo è machine learning e non vera e propria intelligenza artificiale, termine di cui “abusiamo”), un bot come ChatGPT potrebbe un giorno scrivere un articolo come questo?

Il Guardian, un famoso giornale inglese, lo ritiene altamente possibile. Riportando il lancio del bot online, ha affermato che: “Professori, programmatori e giornalisti potrebbero trovarsi tutti senza lavoro nel giro di pochi anni“.

E il giornale britannico dovrebbe saperlo: nel 2020 ha pubblicato un blog scritto da uno dei precursori di ChatGPT, un bot chiamato GPT-3. Nel pezzo, il bot dichiarava che gli esseri umani non avevano nulla da temere dall’IA… una magra consolazione, forse, per gli scrittori professionisti.

Anche perché c’è un altro precedente, forse persino più preoccupante: il “robot killer” (come fu subito soprannominato) Sophia, robot umanoide della Hanson Robotics. Sophia, nel 2016, dichiarò che non avrebbe avuto problemi ad uccidere tutti gli umani.

Proprio così. I dettagli li trovate in questo articolo di Buzzworthy. Forse Skynet è realmente vicina, come diceva il famosissimo film Terminator di James Cameron nell’ormai preistorico 1984. Ed un futuro dominato dalle macchine ci vedrebbe (forse) inevitabilmente ridotti a semplici pile, come nell’altrettanto famoso Matrix.